转载自公众号【十八设计周UI】 作者:十八设计周UI 已授权 头图由设计师陈逍遥生成

Stable Diffusion秋叶整合包,一键安装Stable Diffusion,门槛极低,完全免费,支持Nvidia全系列显卡。

来自B站up主秋葉aaaki近期推出的Stable Diffusion整合包v4.6版本,能够让零基础用户轻松在本地部署Stable Diffusion,适合希望使用AI绘画的朋友。

Stable Diffusion(SD)是什么?

Stable Diffusion是一款2022年发布的文本到图像生成模型,由Stability AI公司与多个学术研究者和非营利组织合作开发。其源代码和模型已经开源,由AUTOMATIC1111在Github上维护一个完整项目,得到全球开发者的共同维护。开源社区对Stable Diffusion的普及做出了重大贡献。

该模型最大特点是开源,可在电脑本地离线运行,适用于大部分配备至少8GB显存的中等性能GPU。推荐的显存为12G。

AI训练与输出结合了深度学习的软硬件原理,常用到Nvidia显卡及相关的CUDA、CUDNN技术,以及xformer、pytorch等深度学习组件。对于希望深入学习AI的用户来说,这些技术需要大量额外的编程学习,可能会感到困难。而秋叶整合包则大大简化了部署过程,使其更易于理解和实施。

Stable Diffusion的基本概念:

大模型:结合素材与SD低模(如SD1.5/SD1.4/SD2.1)经深度学习炼制而成的高级模型,直接用于生成图片。大模型是决定出图大方向的基础底料,主要扩展名为CKPT/SAFETENSORS。

VAE:类似于滤镜,对大模型进行补充,稳定画面色彩范围,常见扩展名同样为CKPT/SAFETENSORS。

LoRA:基于特定大模型深度学习炼制的模型插件,需配合大模型使用,能在中小范围内调整出图风格或补充大模型缺失的元素。根据SD底模炼制的LoRA在不同大模型间切换时具有较好的通用性,而基于特定大模型炼制的LoRA可能在配合时展现出更佳的效果。ControlNet:高级模型插件,赋予SD“视觉”,能基于现有图片获取线条或景深信息,进而用于图片处理。

Stable Diffusion Web-UI(SD-WEBUI):由开源大师AUTOMATIC1111基于Stability AI算法开发的软件,支持通过图形界面在浏览器中操作SD。

秋叶包:中国开发者秋叶制作的整合包,考虑到WEBUI基于GitHub的部署通常需高网络和Python环境支持,秋叶包内置隔离的Python环境和Git,无需深入了解这两软件即可运行,极大降低了使用门槛,使更多人能享受AI绘图乐趣。

如何安装Stable Diffusion秋叶整合包?

- 确认配置要求:

- 系统:需运行Windows 10或更高版本的操作系统。

- 显卡:推荐使用Nvidia品牌的独立显卡,并确保显存容量达到6GB以上。若仅用于生成图像,6GB显存足够;若计划进行模型训练,则建议显存容量为12GB以上。

查看显卡型号的步骤:

- 在电脑左下角的Windows图标上右键点击;

- 选择“设备管理器”;

- 在设备管理器中找到“显示适配器”,即可查看显卡型号信息。

- 文件下载与解压:

- 可从指定来源免费下载文件至本地电脑,并将文件解压至D盘。注意,解压路径最好不包含中文目录,以避免可能的兼容性问题。

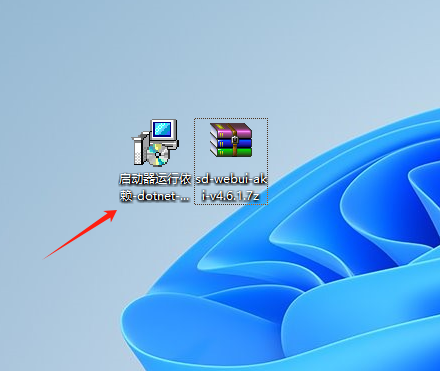

一、打开下载好的安装包(文末获取)

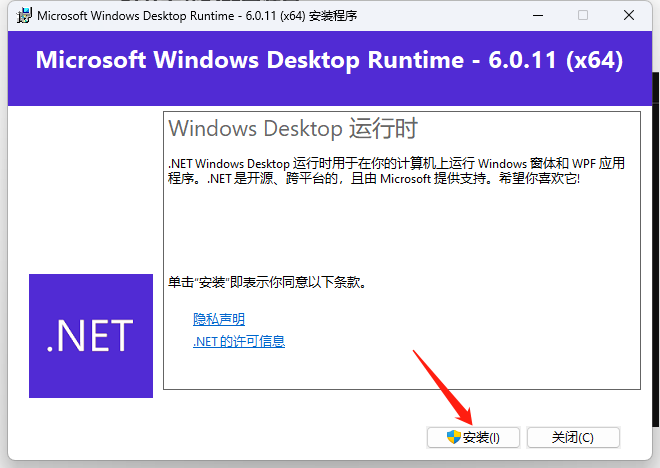

1、安装

2、安装中

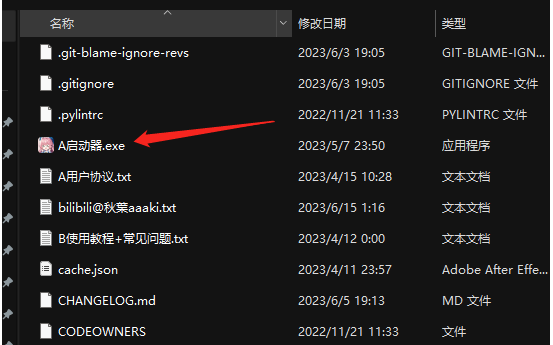

二、解压启动AI绘画

1、解压

2、启动

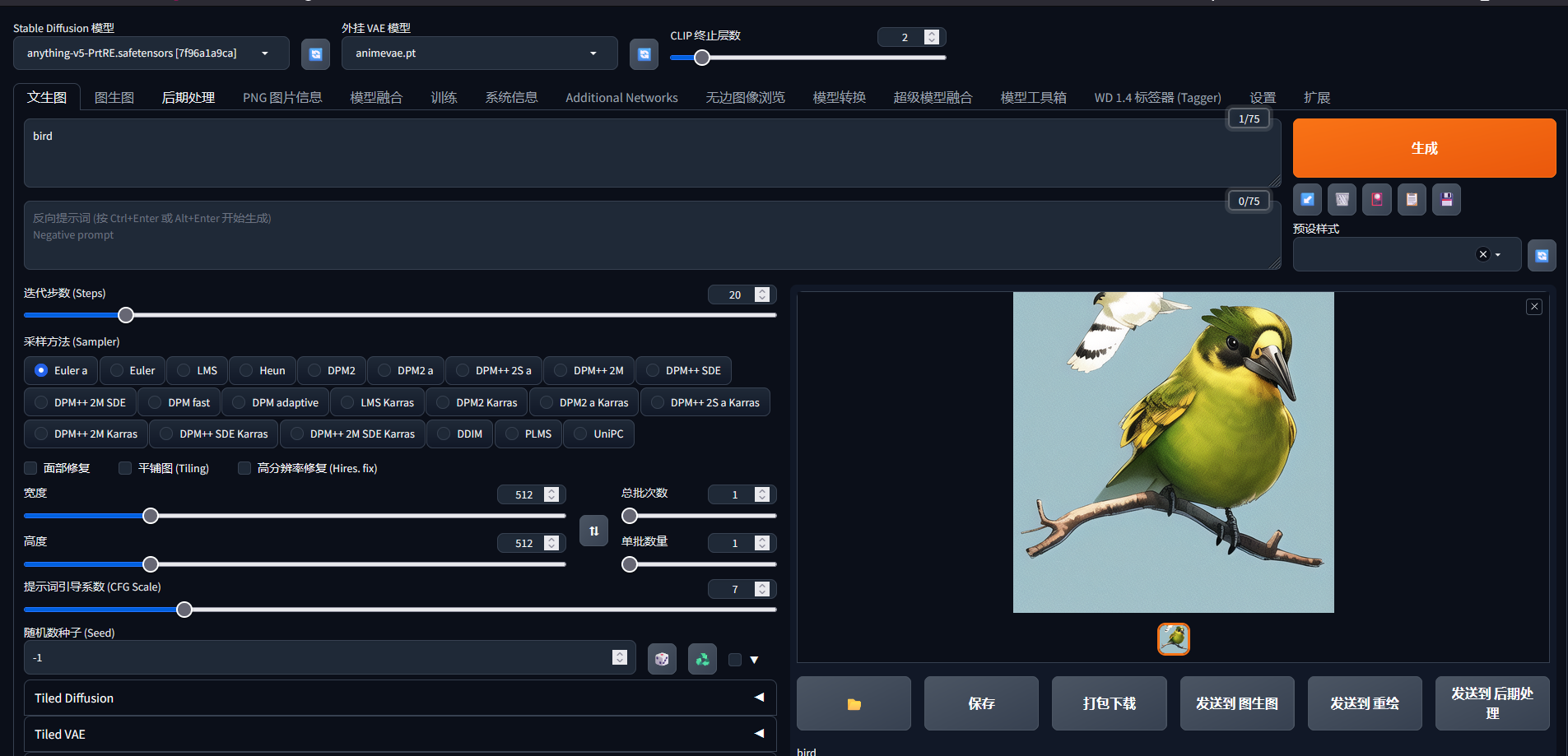

三、开始使用

四、下载模型和安装模型路径

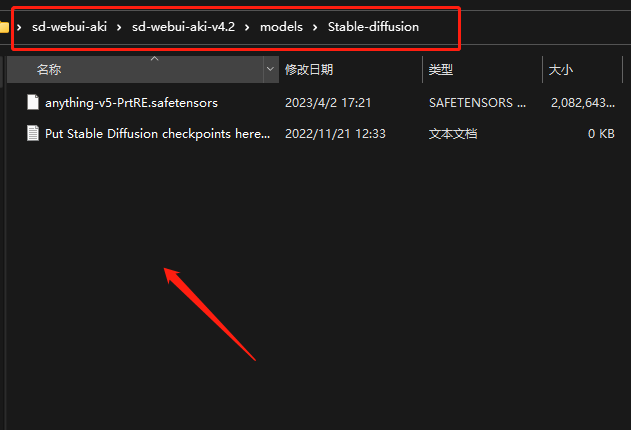

1.安装路径

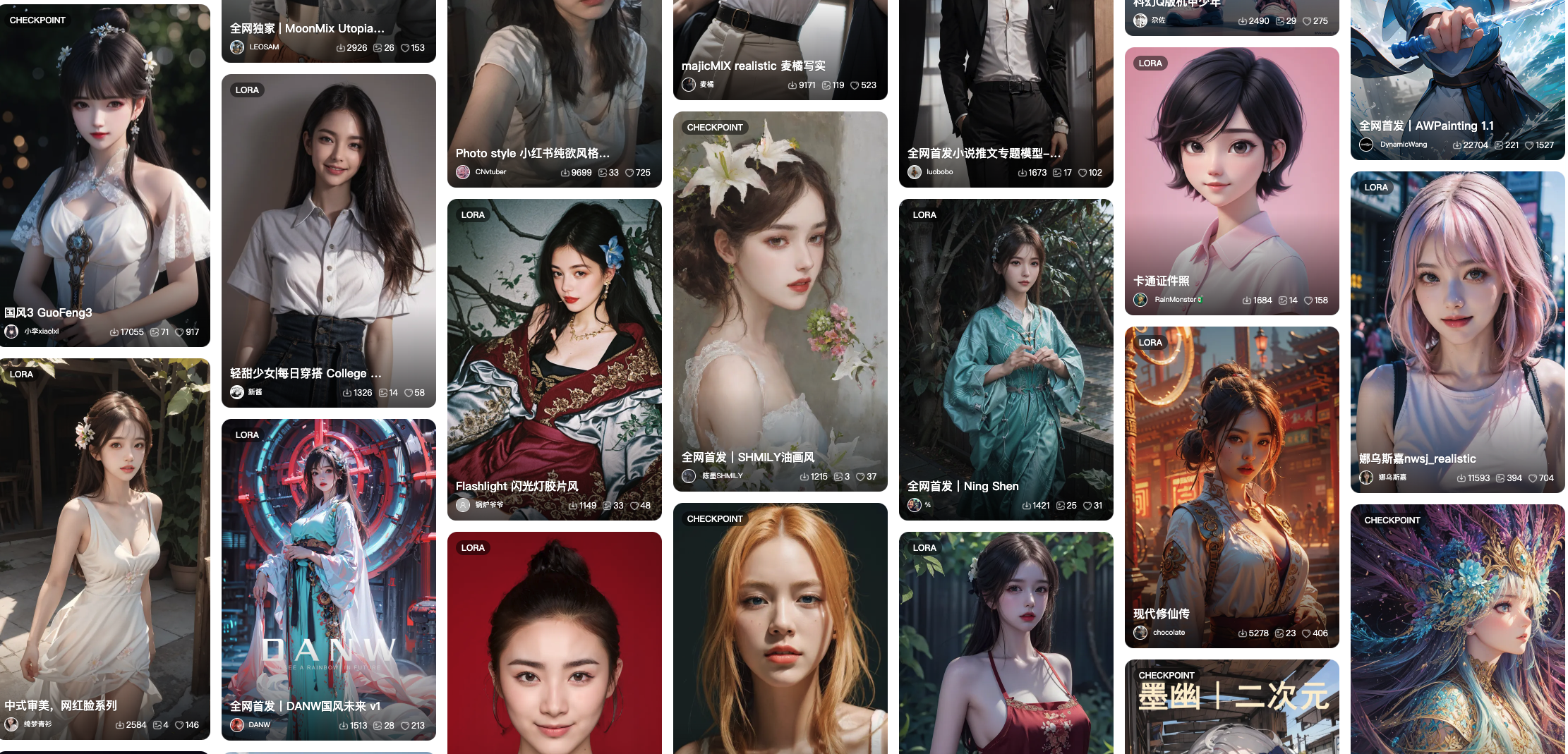

2. 模型下载地址根据需求下载

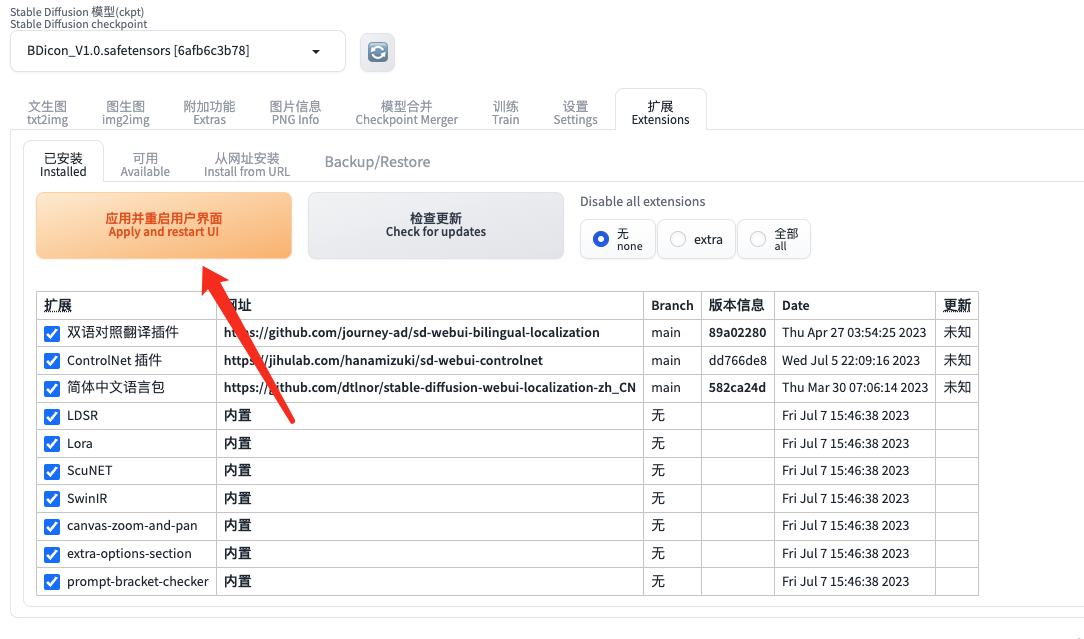

3.放进对应的目录后刷新后,就可以在左边选择对应的模型。

五、 Controlnet插件安装(后台回复的文件已经自带该插件)

1.打开webui复制下方链接到图片中的指示位置点击安装

2.Controlnet模型安装(文章末下载)根据图片路径移动模型文件过去

3. 回到webui重启

六、 配置跟不上,推荐云电脑

最近,我发现有一个全新的解决方案来解决Stable-Diffusion的部署问题,这就是使用青椒云远程服务。通过这种方式,你无需自行部署Stable-Diffusion,不需要担心硬件要求,也不用担心兼容性问题。

青椒云远程服务的使用体验类似于远程控制一台Windows电脑,远程服务器上预装了各种常用大模型,甚至可以提供高达300G的系统盘空间。你只需打开远程服务,即可开始使用Stable-Diffusion,无需繁琐的安装过程。

这对于那些由于部署难度而无法使用Stable-Diffusion的小伙伴来说是一个很好的解决方案。通过使用青椒云远程服务,你可以更方便地体验Stable-Diffusion的魅力。

1、通过下方链接注册下载安装即可

2、注册好后下载对应自己电脑的版本

3、选择自己一个需要的云电脑使用即可,里面包含了模型、插件和汉化内容具体自行体验,不使用的时候记得关机!